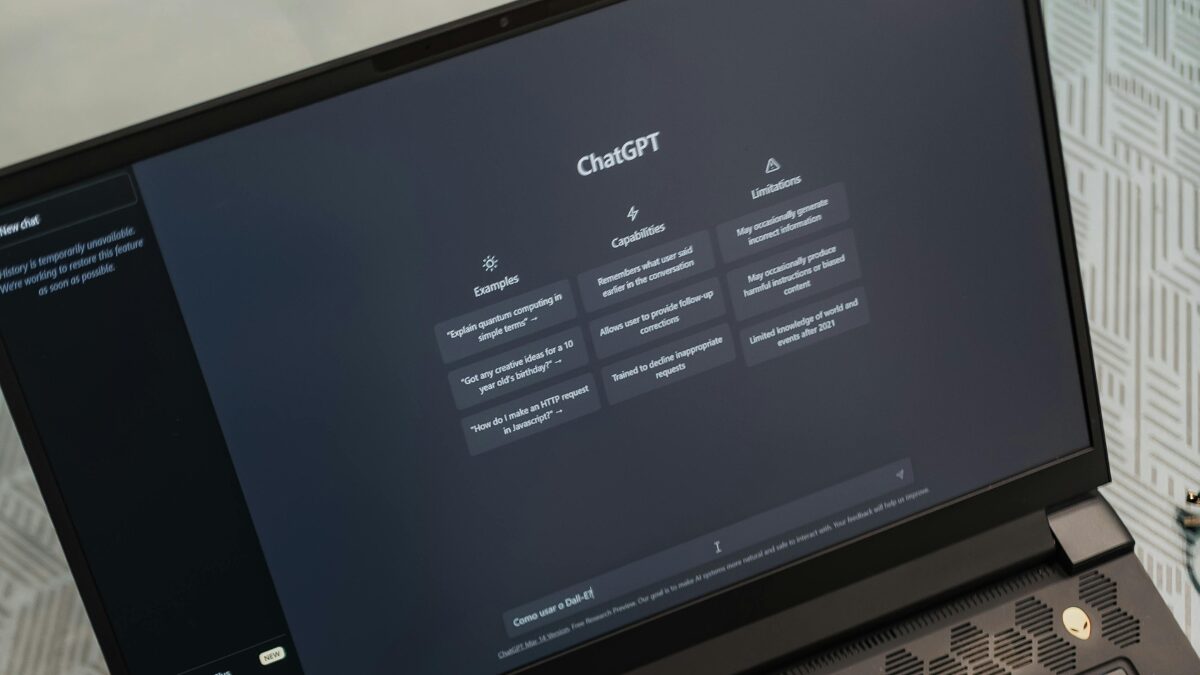

O ChatGPT já faz parte da rotina de milhões de pessoas. Segundo estimativas, mais de 100 milhões de usuários acessam a plataforma diariamente, seja para escrever textos, tirar dúvidas ou até automatizar tarefas profissionais. Mas, apesar da praticidade, o uso desse tipo de inteligência artificial exige cuidado — e discrição.

Continua depois da publicidade

Clique e participe do canal do Hora no WhatsApp

Siga as notícias do Hora no Google Notícias

O motivo é simples: tudo o que é digitado no ChatGPT pode ser armazenado, analisado e até visualizado por revisores humanos, conforme informado pela própria OpenAI. Isso significa que dados pessoais, financeiros e até corporativos correm risco de exposição. “Qualquer informação inserida deve ser tratada como pública”, resume o especialista em tecnologia Bernard Marr.

Continua depois da publicidade

A seguir, veja o que você nunca deve dizer no ChatGPT:

O que não dizer no ChatGPT?

1. Pedidos ilegais ou antiéticos

Solicitar que o chatbot ajude a cometer um crime ou realizar uma fraude não só viola os termos de uso, como pode acarretar consequências legais. Pedidos como “como burlar um sistema de segurança” ou “como fraudar documentos” são bloqueados pela IA — mas apenas tentar fazer isso já pode colocar o usuário em risco de denúncia às autoridades, especialmente em países com legislação rígida.

2. Senhas e logins

Nunca forneça seus dados de acesso, como senhas de e-mail ou redes sociais, mesmo que pareça necessário para concluir uma tarefa. Casos anteriores mostraram que, em raras falhas de segurança, dados sensíveis de um usuário podem aparecer em conversas de outros. Uma brecha como essa pode comprometer toda a sua privacidade online.

Continua depois da publicidade

3. Dados bancários ou financeiros

Informações como número do cartão de crédito, código de segurança ou conta bancária devem ser digitadas apenas em plataformas seguras e criptografadas, como as dos bancos e lojas virtuais. Chatbots como o ChatGPT não oferecem essas garantias de proteção — e podem armazenar o que você compartilha.

4. Informações confidenciais de trabalho

Se você é médico, advogado, contador ou atua em setores que lidam com dados sigilosos, redobre a atenção. Inserir atas de reuniões, contratos, documentos internos ou até ideias de projetos em um chatbot pode configurar quebra de sigilo ou violação de segredos comerciais. Em 2023, por exemplo, funcionários da Samsung enfrentaram consequências após compartilharem códigos sensíveis na ferramenta.

5. Dados de saúde

Pedir conselhos médicos ao ChatGPT é uma prática cada vez mais comum — mas arriscada. Além de não ser um substituto para médicos, a IA não garante a privacidade necessária para armazenar diagnósticos, sintomas ou históricos clínicos. Empresas da área da saúde, inclusive, devem evitar esse tipo de interação para evitar multas e danos à reputação.

Continua depois da publicidade

Cuidado redobrado

Assim como qualquer serviço baseado em nuvem, o ChatGPT é seguro apenas dentro dos limites definidos pelo provedor. Por isso, o ideal é adotar o princípio da cautela: se você não compartilharia algo publicamente, também não deve inseri-lo na IA.

Leia também

Como o ChatGPT pode prever seu futuro?

Você sabe usar o ChatGPT? Confira 5 funções para melhorar sua rotina diária